LLMO, GEO, AEO – Was steckt hinter diesen Abkürzungen?

Die digitale Landschaft verändert sich: Generative KI-Anwendungen wie ChatGPT, Claude, oder Perplexity könnten den klassischen Suchmaschinen schon bald erhebliche Marktanteile abnehmen. Für Unternehmen stellt sich die entscheidende Frage: Wie bleiben wir sichtbar, wenn Nutzer ihre Informationen nicht mehr nur über Suchmaschinen, sondern direkt über KI-gestützte Antwortmaschinen beziehen?

Die Bezeichnungen Large Language Model Optimization (LLMO), Generative Engine Optimization (GEO) oder Answer Engine Optimization (AEO) adressieren genau diese Herausforderung – sie beschreiben die logische Weiterentwicklung von SEO im Zeitalter der generativen KI.

Während früher die Top-10 Ergebnisse einer Suchmaschine entscheidend waren, fällt heute die Aufmerksamkeit auch darauf, wie KI-Systeme Webseiteninhalte interpretieren und in Antworten einfließen lassen. Diese neuen Begriffe stehen für Strategien, die darauf abzielen, Webseiten sowie deren digitale Autorität so zu optimieren, dass sie für KI-Modelle besonders relevant werden.

Dieser Artikel zeigt dir, warum SEO weiterhin relevant bleibt, wie sich die neuen Disziplinen der Suchlandschaft einordnen lassen, warum sie für deine digitale Präsenz zunehmend an Bedeutung gewinnen und welche Chancen sich daraus ergeben.

Wie verändert sich SEO?

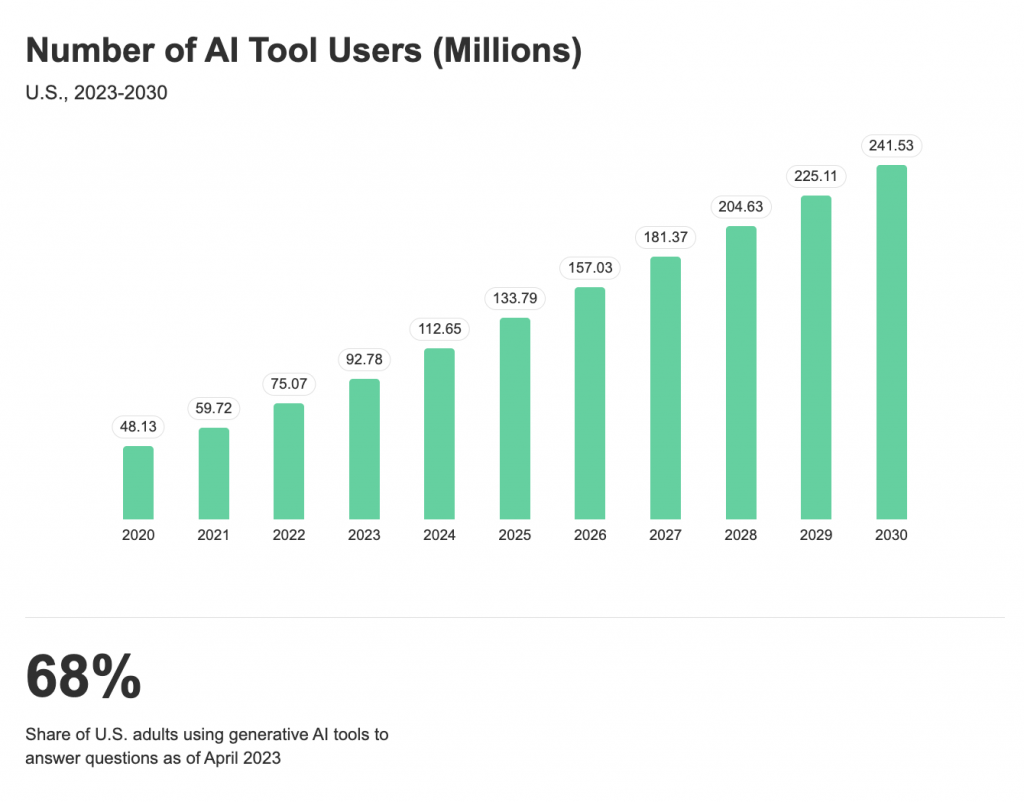

Laut Gartner-Prognosen könnte das Traffic-Volumen traditioneller Suchmaschinen bis 2026 um 25% sinken, da KI-gestützte Antworten an Bedeutung gewinnen (Searchengineland, 2024) [1]. Sichtbarkeit entsteht zunehmend nicht mehr allein über klassische Suchergebnisse. Aktuelle Daten von Statista zeigen zudem: Bereits 2023 nutzten 13 Millionen US-Amerikaner generative KI als ihr primäres Werkzeug für Online-Suchen – eine Zahl, die bis 2027 auf beeindruckende 90 Millionen ansteigen soll. Diese Entwicklung ist Teil eines größeren Trends: Die Gesamtzahl der KI-Tool-Nutzer in den USA wächst von 48 Millionen (2020) auf prognostizierte 241 Millionen (2030). Bereits heute nutzen 68% der US-Erwachsenen generative KI-Tools, um Antworten auf ihre Fragen zu finden – ein deutliches Signal dafür, dass sich das Suchverhalten fundamental wandelt. (Statista, 2024) [2]

Neuere Forschungen, insbesondere die Princeton-Studie “GEO: Generative Engine Optimization”, zeigen, dass diese Optimierungsmethoden die Sichtbarkeit von Quellen in generativen Antworten um bis zu 40% steigern können (Princeton, 2024) [3]. Wer in KI-generierten Antworten erscheinen möchte, sollte “einfach gesagt” gut strukturierte, vertrauenswürdige und für Sprachmodelle verarbeitbare Webseiten entwickeln – wobei dieses Optimierungsfeld derzeit noch echte Pionierarbeit darstellt, da belastbare Erkenntnisse noch Mangelware sind.

Paradigmenwechsel:

- Von der Suche zur direkten Antwort

- Von Klicks zur Informationsextraktion

- Von Listen zu konkreten Empfehlungen

Voraussetzungen für die Optimierung in KI-Systemen

Welche KI-Systeme lassen sich überhaupt optimieren?

Du kannst nicht jedes KI-System so beeinflussen, dass es deine Marke oder Website bevorzugt erwähnt. Ob sich Optimierungsmaßnahmen wie Large Language Model Optimization (LLMO), Generative Engine Optimization (GEO) oder Answer Engine Optimization (AEO) überhaupt lohnen, hängt von einer entscheidenden Eigenschaft ab: Das KI-System muss aktiv externe Inhalte aus dem Internet abrufen können.

Die drei Haupttypen von KI-Systemen im Vergleich

Klassische Large Language Models (LLMs)

Diese Systeme sind auf den direkten Dialog mit dir als Nutzer spezialisiert und generieren kohärente, kontextuelle Antworten basierend auf ihrem Training. Das Problem dabei: Ihr Wissen ist “eingefroren” – sie werden nur alle ein bis zwei Jahre mit neuen Datensätzen trainiert und haben daher einen festen Wissensstichtag (Knowledge Cutoff). Somit ist die Wissensaufnahme hier eher statischer Natur. Aktuelle Ereignisse oder neue Informationen kennen sie schlichtweg nicht.

Klassische Suchmaschinen (Information Retrieval “IR”)

Information Retrieval (IR) Systeme dienen dazu, Informationen aus externen Dokumentensammlungen, Datenbanken oder Wissensdatenbanken zu erschließen. Sie können sowohl auf statische als auch auf dynamisch aktualisierte Datenquellen zugreifen. Im Gegensatz zu klassischen LLM´s, die auf Trainingsdaten basieren, sind IR-Systeme darauf ausgelegt, vorhandene Inhalte gezielt zu durchsuchen und relevante Informationen effizient bereitzustellen. Dabei liefern sie typischerweise eine geordnete Liste von Dokumenten, Suchergebnissen (Suchmaschinen) oder Textpassagen, oft ergänzt durch Metadaten wie Quelle, Veröffentlichungsdatum oder Relevanzbewertung. Manko: Sie können die gefundenen Daten nicht kontextuell interpretieren oder zu einer zusammenhängenden Antwort verarbeiten.

RAG-Systeme (Retrieval-Augmented Generation)

Diese Hybrid-Systeme kombinieren das Beste aus beiden Welten – sie nutzen Suchfunktionen, um aktuelle Informationen abzurufen, und verwenden dann LLM-Technologie, um diese zu einer verständlichen Antwort zu verarbeiten. Dadurch liefern sie dir präzisere, faktenbasierte und aktuelle Antworten, da sie sowohl auf statisches Training als auch auf dynamische Datenquellen zugreifen können.

Warum nur retrieval-basierte Systeme optimierbar sind

Hier liegt die entscheidende Erkenntnis: Nur KI-Systeme mit Retrieval-Funktionen (wie RAG-Systeme oder moderne KI-Assistenten mit Web-Browsing) lassen sich aktiv durch LLMO/AEO/GEO-Maßnahmen beeinflussen. Der Grund ist simpel: Diese Systeme rufen aktiv externe Inhalte ab – und genau diese Inhalte kannst du als Website-Betreiber optimieren, um in den KI-Antworten besser repräsentiert/zitiert zu werden. Bei klassischen LLMs hingegen ist das Wissen bereits “eingebacken” und kann nicht nachträglich beeinflusst werden.

Zwei Ansätze: Wie ChatGPT und Google AI Overviews Antworten generieren

Die Art, wie KI-Systeme ihre Antworten erstellen, unterscheidet sich fundamental – und diese Unterschiede haben direkte Auswirkungen darauf, ob und wie sich Inhalte für bessere Sichtbarkeit optimieren lassen.

ChatGPT folgt primär einem klassischen Ansatz: Das System generiert Antworten hauptsächlich aus seinem trainierten Sprachmodell, das auf einem festen Datenbestand basiert. Optional kann es jedoch auch auf Live-Webinhalte zugreifen, beispielsweise über die Bing-Suche, wodurch aktuelle Informationen in die Antworten einfließen können.

Google AI Overviews hingegen setzt konsequent auf Live-Daten: Das System nutzt Googles umfangreiche Webinhalte und Indexdaten und setzt gezielt Abschnitte aus verschiedenen Web-Quellen zu kohärenten Antworten zusammen. Dieser Retrieval-basierte Ansatz macht die AI Overviews grundsätzlich empfänglicher für Optimierungsmaßnahmen.

Fakten statt Wahrscheinlichkeiten: Wie Grounding KI verlässlich macht

Grounding bezeichnet ein fundamentales Prinzip, das bestimmt, ob KI-Antworten auf verlässlichen Grundlagen stehen oder lediglich auf statistischen Wahrscheinlichkeiten basieren. Dieser Unterschied entscheidet maßgeblich über die Qualität und Vertrauenswürdigkeit der generierten Inhalte.

Bei Menschen funktioniert Grounding auf natürliche Weise, da Aussagen meist auf konkreten Erfahrungen, Beobachtungen oder überprüfbaren Informationen beruhen – man sagt nicht einfach, was vermutlich richtig ist, sondern bezieht sich auf das, was man wirklich weiß. Bei KI-Systemen ist dieser Vorgang technischer und komplexer: Ohne Grounding basieren die Antworten vor allem auf Wahrscheinlichkeiten und Mustern aus den Trainingsdaten, mit Grounding hingegen greifen sie auf reale, überprüfbare Daten oder Dokumente zurück, um ihre Aussagen abzusichern.

Praktisches Beispiel: Auf die Frage “Wie hoch ist der Mount Everest?” würde eine KI mit Grounding antworten: “8.848 Meter”, basierend auf aktuellen geologischen Messungen. Ohne Grounding könnte eine plausibel klingende, aber möglicherweise veraltete oder ungenaue Höhenangabe entstehen. Mehr dazu unter Wie entsteht eine KI Antwort.

Grounding Prozess: Gemini

Im Kontext von Googles Gemini-Modellen hat Dan Petrovic interessante Einblicke in den sogenannten Grounding-Prozess geliefert – also den Mechanismus, mit dem das Sprachmodell bei Bedarf externe Informationen heranzieht, um eine fundierte, aktuelle Antwort zu liefern. Doch nicht jede Anfrage profitiert von dieser Echtzeit-Recherche. Daher hat Google einen Mechanismus entwickelt, um gezielt zu entscheiden, wann Grounding sinnvoll ist. ) (Dejan, 2025) [4].

Der zentrale Baustein ist die „dynamische Abrufkonfiguration“:

Diese analysiert jede Nutzeranfrage und weist ihr einen Vorhersagewert (Prediction Score) zwischen 0 und 1 zu. Je höher der Wert, desto größer der Nutzen durch Grounding. Der Standard-Schwellenwert liegt bei 0,3 – ab diesem Wert wird Grounding aktiviert.

Funktionsweise:

- Prediction Score:

- 0 = Grounding bringt kaum Vorteile

- 1 = Grounding ist sehr nützlich

- Entscheidungskriterium:

- Ist der Score ≥ 0,3 → Grounding wird aktiviert → Antwort basiert auf aktuellen Suchdaten

- Ist der Score < 0,3 → Antwort erfolgt nur auf Basis des Modellwissens

Vorteile dieser selektiven Anwendung:

- Geringere Latenzzeiten: Keine Verzögerung bei einfachen, allgemeinen Fragen

- Kostenersparnis: Suchabfragen werden nur durchgeführt, wenn sie wirklich helfen

- Mehr Genauigkeit bei wichtigen Fragen: Vor allem bei aktuellen Ereignissen oder faktenbasierten Themen

Wie funktioniert der Prozess im Detail?

- User-Query als Ausgangspunkt: Die ursprüngliche Nutzeranfrage (Prompt) dient als Basis.

- Entscheidung: Grounding nötig oder nicht: Das System bewertet, ob die vorhandenen Trainingsdaten ausreichen. Bei aktuellen oder komplexen Fragen entscheidet es sich häufig für Grounding.

- Automatisierte Websuche: Das Modell zerlegt die User-Query in mehrere spezifische Suchanfragen – ähnlich wie ein Mensch, der eine Suchmaschine nutzt.

Beispiel: Aus „Tell me about AI models“ könnten Suchanfragen wie „most popular AI models 2025“, „types of neural networks“, „AI model comparison“ entstehen. - Dokumentensammlung: Die Suchmaschine liefert relevante Inhalte, die dann vom Modell verarbeitet und in die Antwort eingebaut werden.

Grounding Prozess: ChatGPT

Auch ChatGPT führt Grounding durch – also das gezielte Nachschlagen von Informationen außerhalb des Modells, z. B. über eine Websuche. Das ist vor allem bei aktuellen, faktenbasierten oder ortsbezogenen Fragen notwendig. Der Prozess läuft in mehreren Schritten ab:

So grounded ChatGPT eine Anfrage

User-Query als Ausgangspunkt: Der Nutzer stellt eine Frage, z. B.:

- „Welche neuen E-Auto-Modelle kommen 2025?“

- „Wie hoch ist das Rentenalter in Frankreich aktuell?“

- „Was sagen aktuelle Studien zur Wirkung von Ashwagandha?“

Query-Rewriting (interne Umwandlung): ChatGPT zerlegt die Frage in eine oder mehrere präzisere Suchanfragen – so wie ein Mensch sie bei einer Suchmaschine formulieren würde:

- „electric cars 2025 new models“

- „France retirement age June 2025“

- „Ashwagandha supplement clinical studies 2025“

Externe Websuche (API): Das Modell verwendet eine Suchschnittstelle (z. B. Bing über die Microsoft-API), um relevante, aktuelle Webdokumente zu finden. Diese werden ausgelesen, zusammengefasst und ausgewertet.

Antwort-Generierung mit Grounding: Die Informationen aus der Websuche werden im Hintergrund als Textabschnitte oder Absätze in den Prompt eingebaut. Daraus wird dann eine fundierte Antwort erstellt – mit Verweisen auf die Quelle, falls der Modus „Browsing“ aktiviert ist.

Was ChatGPT gut erkennt – und was nicht

- Domains wie „zeit.de“ oder „nature.com“ können zuverlässig erkannt und priorisiert werden. Das Modell bewertet die Vertrauenswürdigkeit anhand von Domain-Signalen.

- Komplexe URLs wie www.beispielseite.de/blog/2023/10/themaX können dagegen schlechter verarbeitet werden – sie enthalten oft irrelevante Parameter oder wirken für ein Sprachmodell unklar.

ChatGPT nutzt beim Grounding ähnliche Mechanismen wie Gemini: Query-Rewriting, Websuche, Einbindung externer Inhalte. Wenn Sprachmodelle wie Gemini / ChatGPT gezielt auf Webinhalte zurückgreifen, um fundierte Antworten zu generieren, steigt die Bedeutung gut auffindbarer, hochwertiger Inhalte. Denn Seiten, die gut ranken, haben eine höhere Chance als „Grounding-Quelle“ genutzt zu werden.

Personalisierung beim Grounding

Wenn Standortdaten oder Memory-Funktion aktiviert sind, bezieht ChatGPT auch diese in die Anfrage ein.

Ein Prompt wie: „Was sind gute Orte zum Wandern in meiner Nähe?“ kann automatisch zu einer Suchanfrage wie

„best hiking trails near Munich 2025“ werden, wenn das Modell weiß, dass du dich in München befindest.

Query Fan-Out: Googles Revolution der KI-Suche

Während das Grounding den Prozess beschreibt, wie KI-Systeme externe Quellen einbeziehen, bestimmt eine noch fundamentalere Technik, welche Quellen überhaupt abgerufen werden: das sogenannte “Query Fan-Out”. Diese von Google entwickelte Innovation verändert die Spielregeln der KI-Optimierung.

Was ist Query Fan-Out?

Query Fan-Out ist Googles proprietäre Technik, bei der eine einzelne Nutzeranfrage vor der eigentlichen Suche automatisch in multiple, semantisch verwandte Sub-Anfragen zerlegt wird. Anders als bei traditioneller Suche, die nach exakten Keywords sucht, antizipiert das System verschiedene Aspekte und Subintentionen der ursprünglichen Frage. (Google, 2025)[5].

Ein Beispiel aus der Praxis:

- Nutzeranfrage: “Beste CRM-Software für kleine Unternehmen”

- Query Fan-Out zerlegt diese in:

- “CRM Software Preisvergleich Startups”

- “Salesforce vs HubSpot kleine Teams”

- “CRM Integration bestehende Tools”

- “DSGVO-konforme CRM deutsche Unternehmen”

- “CRM Implementierung Zeitaufwand KMU”

Parallele Verarbeitung der Sub-Queries

Nach dem Query Fan-Out verarbeitet Google AI Mode alle generierten Sub-Queries gleichzeitig – nicht nacheinander. Das System “ruft Informationen für alle Fan-Out-Queries simultan ab und erweitert den verfügbaren Informationspool für die Antwort-Synthese”.

Praktisches Beispiel: Für “Beste CRM-Software für kleine Unternehmen” laufen parallel:

- Suche nach “CRM Software Preisvergleich Startups”

- Suche nach “Salesforce vs HubSpot kleine Teams”

- Suche nach “CRM Integration bestehende Tools”

- Suche nach “DSGVO-konforme CRM deutsche Unternehmen”

- Suche nach “CRM Implementierung Zeitaufwand KMU”

Die neue SEO-Realität, die durch Query Fan-Out entsteht

- Nicht mehr nur: Rankings zwischen Position 1-10 für ein Keyword

- Sondern: Semantische Relevanz für ein Spektrum verwandter Suchanfragen

- Nicht mehr nur: Ganze Seiten ranken

- Sondern: Einzelne Textpassagen werden ausgewählt

- Nicht mehr: Ein Suchergebnis = Ein Klick

- Sondern: Ein Suchergebnis = Synthese aus multiplen Quellen

Strategische Implikationen für Content-Ersteller

Da Google Query Fan-Out als proprietäre Technik in seinen dominanten KI-Features einsetzt, wird die Optimierung dafür zunehmend geschäftskritisch. Die wichtigsten Handlungsfelder:

- Content-Architektur überdenken: Jeder Textabschnitt muss semantisch vollständig und eigenständig wertvoll sein, da einzelne Passagen unabhängig ausgewählt werden können.

- Themen-Cluster statt Keywords: Unternehmen müssen ihre Content-Strategie von der Keyword-Optimierung auf die semantische Abdeckung von Themen-Clustern umstellen, die alle verwandten Sub-Queries abdecken.

- Passage-Optimierung: Da Google jetzt auf Textabschnitt-Ebene indexiert, sollte jeder Absatz eine spezifische Frage präzise beantworten können.

Praktische Anwendung: Prompt-Recherche als neues Werkzeug

Was ist Prompt-Recherche – und wie nutzen wir sie?

In klassischen SEO-Tools wie dem Keyword Planner bekommen wir Suchvolumen und Wettbewerbsdaten, aber nicht, welche Prompts in KI-Systemen eingegeben werden. Deshalb haben Agenturen begonnen, eigene Recherche-Tools zu entwickeln:

Ein Custom-GPT, das gezielt danach gefragt wird, welche Prompts häufig gestellt werden

Prompt 1

"Welche typischen und häufig gestellten Prompts oder Fragen stellen Nutzer von Large Language Models (LLMs) zum Thema CRM-Software?"Daraus generieren wir eine Liste typischer Nutzerprompts:

Prompt 2

"Bitte gib mir die relevanten Suchanfragen (Search Queries) zu Prompt Nummer 2 zurück und nenne dazu die Quellen, die während des Grounding-Prozesses zur Informationsgewinnung verwendet wurden.“Im Anschluss erhalten wir die dazugehörigen Search Queries samt Quellen, die aus dem Prompt abgeleitet werden und erkennen, welche Grounding-Prozesse angestoßen werden:

Die Online-Suche (z. B. via Bing in ChatGPT) signalisiert, dass Grounding läuft. Hierbei versucht das Modell, Webinhalte dynamisch zu laden, um die Antwort mit aktuellen Daten anzureichern. Die Quellen, die dann erscheinen, geben Hinweise auf Content-Typen, Tonalität und Domain-Trust.

Diese Auflistung zeigt dir, welche Content-Typen besonders gut performen. An dieser Stelle lässt sich der klassische Optimierungsansatz effektiv anwenden: Vergleiche deine eigenen Webauftritt mit denen der erfolgreichsten und relevantesten Wettbewerber, die in den Beispielen genannt wurden. Analysiere, welche Inhalte und Strategien sie einsetzen – und worin sie sich von dir unterscheiden.

Studienlage: Wie stark ist der SEO-Einfluss wirklich?

Wie groß ist nun der Einfluss klassischer SEO auf die Auswahl der Quellen durch KI? Aktuelle BrightEdge-Analysen zeigen ein differenziertes Bild, das stark vom jeweiligen KI-System abhängt (BrightEdge, 2024 [6] & BrightEdge, 2025 [7]):

Perplexity (Stand: April 2024):

- 60% Overlap zwischen Perplexity-Zitierungen und Google Top 10 Rankings

- Starke Branchenunterschiede: Healthcare zeigt 82% Overlap, Restaurants nur 27%

- Durchschnitt: 5,28 Zitierungen pro Antwort

- Wachstum: 40% monatlicher Anstieg bei Website-Referrals

Google AI Overviews (Stand: April 2025):

- Nur 15-16% Overlap mit Google Top 10 organischen Ergebnissen

- Abnehmender Trend: Nach dem März 2025 Core Update sank der Overlap von 16% auf 15%

- Branchenverschiebungen: Travel (+6,6%), Entertainment (+4,9%), Restaurants (+4,6%) zeigen steigende Zitierungen außerhalb der Top 10

Zentrale Erkenntnisse:

System-spezifische Unterschiede: Verschiedene KI-Plattformen priorisieren unterschiedlich – Perplexity korreliert stärker mit SEO-Rankings als Google AI Overviews.

Branchenabhängigkeit: Authoritative Bereiche wie Healthcare zeigen höhere SEO-Korrelation, während lokale Services (Restaurants) stärker abweichen.

Zeitliche Entwicklung: Der Trend zeigt eine abnehmende Korrelation zwischen traditionellen SEO-Rankings und KI-Zitierungen.

Gutes SEO erhöht weiterhin die Wahrscheinlichkeit für KI-Zitierungen, aber die Systeme entwickeln zunehmend eigene Bewertungskriterien. Content außerhalb der Top 10 hat bessere Chancen als früher angenommen.

Wie kann ich die Sichtbarkeit meiner Marke in KIs messen?

Herausforderungen: Personalisierung, Metriken & Reproduzierbarkeit

Ein offenes Thema ist die Messbarkeit in der LLMO-Welt: Die Frage: Können wir Markensichtbarkeit noch messen, wenn LLMs keine Rankings und keine Klicks erzeugen? Antwort: Es ist schwierig. Die klassische SEO-Metrik (Ranking → Klick → Traffic) greift hier nur bedingt. Reproduzierbarkeit: Auch dieselben Prompts führen nicht zwingend zu denselben Quellen – insbesondere bei dynamischem Grounding über Bing oder Google.

Bei AI Overviews und Chatbots wie ChatGPT oder Perplexity werden Antworten zunehmend personalisiert oder situationsabhängig erstellt – das erschwert valide Monitoring-Strategien.

Erste Tools für LLMO-Monitoring entstehen

Trotz dieser Herausforderungen entwickeln sich bereits erste Messinstrumente für die KI-Ära. Diese Tools versuchen, strukturiert zu erfassen, wie oft und in welchem Kontext Marken in LLM-Antworten erwähnt werden.

Beispiel eines pragmatischen Ansatzes: Ein neues Tool misst Markenerwähnungen systematisch über die fünf wichtigsten LLMs hinweg – ChatGPT, Gemini, Claude, Grok und Perplexity. Das Konzept dahinter ist bewusst einfach gehalten:

- Branchenspezifische Prompts: Es werden die beliebtesten kommerziellen Sucheingaben pro Branche erstellt, basierend auf realen Suchvolumen

- Fokus auf Schlüsselbranchen: 15 wichtige Branchen werden abgedeckt – von Reisen und Automobil über E-Commerce und Finanzen bis hin zu Gesundheit und Bildung

- Erwähnungs-Tracking: Gemessen wird der Prozentsatz der Domain-Erwähnungen (inklusive Markennennung) über alle LLMs und getesteten Prompts innerhalb der jeweiligen Branche

Die Realität: Ja, Modelle ändern sich ständig, Antworten variieren selbst bei identischen Prompts, und viele denken “dafür ist es noch zu früh.” Dennoch findet der Wandel bereits statt – leise, aber kontinuierlich unter der Oberfläche.

Der Kostenfaktor: Ein wichtiger Aspekt bei der Entwicklung solcher Tools sind die hohen Token-Kosten der LLMs. Während andere LLM-Sichtbarkeitstools oder Add-ons entsprechend teuer sind, experimentieren erste Anbieter mit kostenlosen Ansätzen, um den Markt zu erschließen.

Diese frühen Monitoring-Ansätze sind noch experimentell, geben aber bereits erste Einblicke darüber, wie LLMs verschiedene Branchen und Marken wahrnehmen und darstellen.

Wie versteht eine KI deine Marke (Entität)?

Eine einfache und spannende Methode, um herauszufinden, wie deine Marke von großen Sprachmodellen (LLMs) wie ChatGPT, Gemini oder Perplexity wahrgenommen wird, ist folgende: Frag die KI direkt. Geb einfach mal ein: „Wer ist [Markenname]?” oder „Was macht [Name der Person oder Firma]?” – und schau dir die Antwort an.

Prompt 1

„Wer ist [Markenname]? oder „Was macht [Name der Person oder Firma]?"

Prompt 2

"In welchem Kontext wird [Markenname] wahrgenommen?"

Wenn du einen klaren, eindeutigen Markennamen hast, wirst du in der Regel eine fundierte, kontextreiche Antwort bekommen. Und genau dieser Kontext ist aufschlussreich: In welchem Zusammenhang wird deine Marke genannt? Welche Themen, Leistungen oder Eigenschaften werden ihr zugeordnet? Das gibt dir einen ersten, schnellen Eindruck davon, wie gut deine Positionierung bereits im KI-Modell verankert ist – und ob sie mit deiner eigenen Markenidentität übereinstimmt.

Darüberhinaus kannst du mit einem weiteren Prompt in die automatisierte Wettbewerbsanalyse starten. Ich habe zusätzlich ein paar Wettbewerber eingetragen – und siehe da: Das Modell ist in der Lage, meine Brand in Relation zu anderen einzuordnen, Stärken und Schwächen zu analysieren und Unterschiede in der Positionierung aufzuzeigen. Eine sehr wertvolle Ergänzung im Kontext von Markenstrategie, aber auch SEO und Content-Marketing.

Prompt 3

Welche Wettbewerber gibt es in diesem Kontext und wie unterscheiden sie sich von [Markenname]?

Was kannst du durch diese Analyse lernen?

1. Markenklarheit & Wiedererkennbarkeit

- Wird deine Marke überhaupt erkannt?

- Ist der Name eindeutig und unterscheidbar?

- Wird klar, wofür du stehst?

2. Positionierung & Kontext

- In welchem thematischen Umfeld taucht deine Marke auf?

- Mit welchen Keywords, Leistungen, Branchen, Themen wird sie assoziiert?

- Welche Rolle spielt die Marke in ihrer Branche laut Modell: Innovator, Dienstleister, Experte?

3. Inhaltlicher Footprint

- Welche Inhalte, Themen oder Aussagen scheinen am stärksten im Modell „verankert”?

- Welche Personen (Gründer:innen, Autor:innen, Speaker:innen) werden im Kontext genannt?

4. EEAT-Indikatoren

- Wie gut wird die Expertise, Autorität und Vertrauenswürdigkeit deiner Marke sichtbar?

- Tauchen Quellen auf (z. B. Website, LinkedIn, Medienberichte), die auf diese Faktoren einzahlen?

5. Vergleich mit Wettbewerbern

- Welche Unterschiede in der Wahrnehmung gibt es zu deinen Mitbewerbern?

- Wirst du als stärker, gleichwertig oder austauschbar wahrgenommen?

Was kannst du danach konkret umsetzen?

1. Markenbotschaften nachschärfen

- Content gezielter ausrichten: „Wer bin ich?” und „Wofür stehe ich?” klarer kommunizieren.

- Inhalte, die nicht zur gewünschten Markenidentität passen, reduzieren oder umformulieren.

2. Content-Strategie optimieren

- Themenschwerpunkte setzen, die im Modell noch nicht stark genug vertreten sind.

- Content wiederverwenden oder verstärken, der bereits gut verankert ist.

3. EEAT gezielt stärken

- Autorenprofile ausbauen (z. B. mit Bio, Fachartikeln, Zitaten).

- Expertenwissen sichtbar machen (Case Studies, Whitepaper, Konferenzbeiträge).

- Glaubwürdige Dritte aktivieren (Presseberichte, Erwähnungen, Reviews).

4. Strukturierte Daten & technische Maßnahmen

- Schema.org-Markup einsetzen, um Entities (Marke, Personen, Produkte) besser maschinenlesbar zu machen.

- Inhalte so strukturieren, dass KIs sie leicht erkennen, clustern und zuordnen können.

5. Wettbewerbsanalyse nutzen

- Eigene Positionierung gezielt gegen Wettbewerber schärfen.

- Contentlücken oder Stärken der Konkurrenz identifizieren und strategisch nutzen.

Sind Markennennungen das neue Linkbuilding?

In gewisser Weise – ja. Zumindest im Kontext von EEAT (Experience, Expertise, Authoritativeness, Trustworthiness) spielen konsistente, thematisch relevante Erwähnungen eurer Marke eine zunehmend wichtige Rolle. Es ist keine neue Modeerscheinung, sondern eine logische Weiterentwicklung von Markenbildung im digitalen Raum.

Wir erleben dabei eine Verschiebung von linkbasierter Autorität zu textbasierter Autorität. Das Suchvolumen der Marke und die Erwähnungen im Internet sind die stärksten Prädiktoren dafür, was die Sichtbarkeit von KI antreibt – im Gegensatz zu SEO, bei dem eher Links und Keywords regierten. Diese Entwicklung unterstreicht, wie wichtig es geworden ist, dass über eure Marke gesprochen wird, nicht nur dass auf sie verlinkt wird.

Was kann ich nun tun, um die Chance auf mehr Sichtbarkeit in der KI zu erhöhen?

Um in Large Language Models (LLMs) sichtbar zu werden, ist ein zentrales Verständnis notwendig: Sichtbarkeit entsteht nur dort, wo ein Grounding stattfindet – also eine Verankerung der KI-Antwort in externen, aktuellen Quellen. Ohne Grounding greift das Modell ausschließlich auf die veralteten Trainingsdaten des Basismodells zurück, die oft Jahre alt sind und neue, unbekannte Entitäten nicht enthalten. Für die meisten Marken und Unternehmen bedeutet das: Ohne Grounding keine Sichtbarkeit – und somit auch keine effektiven Optimierungsansätze für Prompts.

Ein zentraler Hebel ist deshalb die Frage: Wird meine Marke oder mein Content in aktuellen, referenzierbaren Quellen abgebildet, die das LLM tatsächlich in den Antwortprozess einbezieht? Daraus ergeben sich weitere strategische Fragen:

- Was sind die zentralen Fragestellungen meiner Zielgruppe in meiner Nische? Nur wer diese versteht, kann Content schaffen, der kontextuell relevant ist.

- In welchen Quellen möchte ich referenziert werden? Muss es immer die eigene Website sein – oder bieten Drittquellen (z. B. Fachportale, Branchenverzeichnisse, Medien) eventuell bessere Chancen, um in das Grounding von LLMs einzufließen?

- Wie gut sind meine Inhalte technisch und semantisch extrahierbar für LLMs? Strukturiert aufbereiteter Content mit klarem Kontext hilft den Modellen, Informationen korrekt zuzuordnen.

- Welche semantischen Begriffe und Themenräume will ich mit meiner Marke besetzen? Nur wenn der sogenannte „Contextmatch“ gelingt – also eine klare Verbindung zwischen Thema, Marke und Nutzerintention entsteht – kann eine KI die Marke passend platzieren.

- Wie demonstriere ich Autorität und Vertrauen in meinem Themenfeld? Sichtbarkeit erfordert Signale von Relevanz und Glaubwürdigkeit, etwa durch hochwertige Erwähnungen, Backlinks und Co-Citations auf themenrelevanten Plattformen.

Letztlich geht es darum, konkurrenzfähige semantische Beziehungen zwischen Marke und Themen zu schaffen – und diese dort zu platzieren, wo LLMs sie auch „sehen“ können. Wer sich dafür strategisch aufstellt, schafft die Grundlagen für LLMO/GEO/AEO – und damit für eine neue Form der digitalen Sichtbarkeit.

Potenzielle Handlungsfelder

| Handlungsfelder | Beschreibung |

|---|---|

| Content | Klare Hierarchien (H1-H6), angemessene Informationsdichte, natürliche und konversationelle Sprache, präzise Antworten auf häufige Fragen, Content-Nuggets, Medienvielfalt (Listen, Tabellen, Infografiken), vertrauenswürdige Quellen, persönliche Erfahrungen, Expertenmeinungen, Zitate, Daten/Fakten/Statistiken, Autorenkennzeichnung |

| Entitäten, Kontext & Autorität | EEAT-Prinzipien (Expertise, Experience, Authoritativeness, Trustworthiness), Omnipräsenz-Strategien, Backlinks, Citations |

| Technik | Maschinenlesbare Formate und semantische Auszeichnungen (Schema.org), Zeitstempel und Aktualitätssignale |

1. Content Optimierung

Schreibstil:

- Authentische Kommunikation: Entwickle einen natürlichen, konversationellen Schreibstil

- Qualität vor Quantität: Verzichte vollständig auf Keyword-Stuffing und setze stattdessen auf semantische Relevanz

- Fachliche Präzision: Verwende branchenspezifische Terminologie gezielt und erkläre komplexe Begriffe verständlich

- Multiperspektivische Darstellung: Beleuchte Themen aus verschiedenen Blickwinkeln und berücksichtige unterschiedliche Standpunkte

- Hybride Content-Entwicklung: Kombiniere menschliche Kreativität mit KI-Unterstützung für optimale Ergebnisse

- Einheitliche Markenkommunikation: Etabliere eine konsistente Ton- und Stilrichtung über alle Inhalte hinweg

Struktur:

- Pyramidale Informationsarchitektur:

- Kernaussage/Executive Summary: Direkte Antwort auf die zentrale Frage

- Vertiefende Analyse: Umfassende Erklärung mit Hintergründen

- Evidenzbasierte Unterstützung: Daten, Studien und Belege

- Erweiterte Kontextualisierung: Zusätzliche Perspektiven und Zusammenhänge

- Multimediale Content-Gestaltung:

- Integriere Listen, Tabellen, Infografiken und Diagramme strategisch

- Produziere Videos mit detaillierten, durchsuchbaren Transkripten

- Entwickle Content in verschiedenen Formaten (visuell, auditiv, textbasiert)

- Semantische HTML-Architektur: Implementiere eine durchdachte H1-H6 Hierarchie, die den Informationsfluss logisch strukturiert

- Ganzheitliche Themenabdeckung: Entwickle umfassende Content-Cluster, die Themenbereiche vollständig durchleuchten

- Benutzerfreundliche Aufbereitung: Strukturiere FAQ-Bereiche und thematische Content-Cluster für bessere Auffindbarkeit

- Optimale Content-Portionierung: Teile Informationen in leicht konsumierbare Abschnitte auf

- Ausgewogene Informationsdichte: Vermeide sowohl oberflächliche als auch überlastende Darstellungen

- Strategische Content-Positionierung: Verhindere Aufmerksamkeitsverlust bei längeren Inhalten durch geschickte Strukturierung

Nutzerintention & Zielgruppe:

- Intentionsbasierte Content-Entwicklung: Identifiziere und adressiere spezifische Nutzerabsichten systematisch

- Suchintention-Content-Alignment: Stelle sicher, dass Headlines und Inhalte präzise auf Nutzeranfragen abgestimmt sind

- Antizipative Antwortgestaltung: Entwickle prägnante Antworten auf häufig gestellte Branchenfragen

- Zielgruppengerechte Informationstiefe: Passe den Detailgrad an das Vorwissen deiner Audience an

- Entscheidungsunterstützung: Integriere ROI-Argumente und Entscheidungshilfen für komplexe Kaufprozesse

- Customer-Journey-orientierter Content: Entwickle Inhalte für alle Phasen der Kundenreise – von der Problemerkennung bis zur Lösungsimplementierung

- Natürlichsprachige Optimierung: Verwende authentische Fragestellungen und FAQ-Formate, die der natürlichen Kommunikation entsprechen

Expertise, Aktualität & Quellen:

- Datengestützte Argumentation: Integriere aktuelle Statistiken,Daten, Fakten und Forschungsergebnisse mit transparenten Quellenangaben

- Aktualitätsmanagement: Versehe zeitkritische Inhalte mit präzisen Zeitstempeln und Aktualisierungshinweisen

- Autoritätsaufbau durch Expertise:

- Dokumentiere Erfolgsgeschichten mit messbaren, nachvollziehbaren Ergebnissen

- Publiziere eigenständige Forschungsarbeiten und Datenanalysen

- Positioniere interne Experten als Meinungsführer in der Branche

- Hebe Qualifikationen, Zertifizierungen und Branchenerfahrung transparent hervor

2. Optimiere Entitäten, Kontext & Autorität

Publikationen & Events:

- Thought Leadership etablieren: Veröffentliche qualitativ hochwertige Fachbeiträge in anerkannten Branchenpublikationen

- Multi-Channel-Präsenz: Engagiere dich aktiv auf Konferenzen, in Podcasts, Webinaren und als Gastredner

- Branchenführerschaft: Übernimm Führungspositionen in Fachverbänden und engagiere dich in Jurys

- Externe Meinungsführerschaft: Etabliere dich durch strategische Gastbeiträge als Experte in deinem Fachbereich

- Qualitätssiegel: Strebe Erwähnungen in “Best of”-Listen und unabhängigen Produktvergleichen an

Multi-Platform-Präsenz:

- Professionelle Netzwerke: Nutze LinkedIn und Twitter gezielt für wertvollen Branchencontent

- Video-Optimierung: Entwickle YouTube-Präsenz mit detaillierten, SEO-optimierten Transkripten

- Marktplatz-Integration: Etabliere Präsenz auf relevanten E-Commerce-Plattformen und branchenspezifischen Marktplätzen

- Community-Engagement: Beteilige dich konstruktiv auf Q&A-Plattformen wie Quora und Reddit

- Einheitliche Markenbotschaften: Gewährleiste konsistente Kommunikation über alle Kanäle hinweg

- Plattformspezifische Anpassungen: Optimiere Content-Formate für die jeweiligen Plattformbesonderheiten

- Reputationsmanagement: Überwache und reagiere proaktiv auf Kundenfeedback über alle relevanten Plattformen

Verlinkungen & Erwähnungen:

- Strategischer Linkaufbau: Fokussiere auf qualitativ hochwertige Backlinks von thematisch relevanten, vertrauenswürdigen Websites

- Citation-Strategie: Arbeite systematisch an unverlinkten Erwähnungen in Fachartikeln und Studien

- Entitätsbeziehungen: Optimiere das gemeinsame Auftreten deiner Marke mit relevanten Branchenattributen

- Attribut-Assoziationen: Identifiziere Schlüsselattribute, die für deine Zielgruppen relevant sind, und stelle systematisch Verbindungen zu deinem Unternehmen her

- Content-Kooperationen: Entwickle Gastbeitrag-Strategien für hochwertige Backlinks und Reichweitensteigerung

- Zitatfähigkeit: Erstelle prägnante, zitatfähige Statements und Expertenmeinungen für Medienvertreter

Verzeichnisse & Bewertungen:

- Knowledge-Graph-Integration: Baue systematisch Präsenz in Wikipedia, Wikidata und Google Business Profile auf

- Branchenverzeichnisse: Registriere dich in relevanten Fachverzeichnissen mit NLP-optimierten Beschreibungen

- User Generated Content: Fördere aktiv Kundenbewertungen, Testimonials und dokumentierte Fallstudien

- Entitätsnetzwerk: Stärke Verbindungen zu etablierten Branchenkonzepten und -akteuren

- Konsistente Darstellung: Gewährleiste einheitliche Unternehmensinformationen in allen externen Verzeichnissen

- Community-Teilnahme: Beteilige dich regelmäßig an Fachdiskussionen in branchenrelevanten Foren und Communities

3. Technik optimieren

Empfohlene Optimierungen:

- KI-Crawler-Optimierung: Überprüfe deine robots.txt-Datei und stelle sicher, dass wichtige KI-Bots wie GPTBot, PerplexityBot oder anthropic-ai nicht blockiert werden

- Performance-Excellence: Optimiere Core Web Vitals, schnelle Ladezeiten, Mobile-Friendliness und HTTPS-Implementierung für bessere Crawler-Zugänglichkeit und mehr Sicherheit

- Technische Fehler beheben: Beseitige Crawling-Fehler und kaputte Links, die die Indexierung durch KI-Systeme behindern könnten

- Architektur-Stabilität: Entwickle und pflege eine saubere, logische Website-Architektur mit klarer Navigationsstruktur

Optionale Optimierungen (Kosten/Nutzen-Aufwand beachten):

- LLMs.txt-Bereitstellung: Erstelle eine llms.txt-Datei zur gezielten Steuerung der KI-Crawler und verbesserten Indexierung durch Large Language Models

- Entitätserkennbarkeit: Stelle sicher, dass deine Marke, Produkte und Schlüsselpersonen als eindeutige Entitäten identifizierbar sind

- Strukturierte Datenintegration: Implementiere umfassendes Schema-Markup:

- Organization Schema: Auf der Startseite verwenden, um deine Marke eindeutig zu definieren

- Product Schema: Für alle Produktseiten mit vollständigen Informationen zu Produkten einsetzen

- FAQPage und HowTo-Strukturen für relevante Inhalte

Analyse und Monitoring:

- LLM-Response-Testing: Teste regelmäßig zielgruppenrelevante Anfragen in verschiedenen KI-Systemen und analysiere deine Sichtbarkeit

- Konkurrenzbeobachtung: Untersuche systematisch, welche Wettbewerber in LLM-Antworten zu deinen Kernthemen erscheinen und analysiere deren Strategien

- Sentiment-Monitoring: Bewerte regelmäßig, wie deine Marke in KI-generierten Antworten dargestellt wird

- Rank Tracking mit AI Overviews: Nutze SISTRIX, um zu identifizieren, für welche deiner aktuell rankenden Keywords zusätzlich AI Overviews angezeigt werden. Prüfe anschließend systematisch, ob deine Inhalte in diesen KI-generierten Zusammenfassungen als Quelle referenziert werden.

- Trend-Identifikation: Erkenne thematische Entwicklungen und Wissenslücken in LLM-Antworten zu deinem Fachbereich

- Traffic-Attribution: Implementiere spezielles Tracking für Referral-Traffic von LLM-Plattformen in Google Analytics 4 mit regex-basiertem Tracking:

^https:\/\/(www\.meta\.ai|www\.perplexity\.ai|chat\.openai\.com|claude\.ai|-

chat\.mistral\.ai|gemini\.google\.com|bard\.google\.com|chatgpt\.com|copilot\.

microsoft\.com|edgeservices\.bing\.com)(\/.*)?$Fazit

Suchmaschinen verschwinden nicht – sie werden transformiert: von Suchlisten zu intelligenten Dialogpartnern. Ganz gleich, ob Suchmaschinen KI als Feature einbinden oder KIs Suchmaschinen nutzen – die Zukunft der Suche liegt im Verstehen und darin, wie wir dabei Sichtbarkeit schaffen. SEO ist nicht tot, sondern wird durch neue Erkenntnisse unter den Konzepten von LLMO, GEO und AEO weiterentwickelt. Auch heute ist man mit Blick auf die Sichtbarkeit in KI-Systemen gut beraten, wenn man SEO – und das, was wir seit Jahren darunter verstehen – weiterhin beherzigt, da nicht zuletzt auch gute Suchmaschinenplatzierungen die Wahrscheinlichkeit erhöhen, dass KI-Systeme im Rahmen von RAG (Retrieval-Augmented Generation) Inhalte über ihre Web-Recherche-Funktionen finden, abrufen und als Referenz in Antworten integrieren. Aber: Luft nach oben wird es immer geben. Also sollten wir testen, monitoren und offen bleiben für alles, was unsere digitale Präsenz morgen nicht schlechter macht.

Quellen

[1]: Will traffic from search engines fall 25% by 2026?

[2] New Report From .Trends & Statista Reveals How AI Search is Changing the Web

[3]: GEO: Generative Engine Optimization

[4]: How Google Decides When to Use Gemini Grounding for User Queries

[5] Expanding AI Overviews and introducing AI Mode

[6] 60% of Perplexity citations overlap with top 10 Google organic results

[7] Google AI Overview-organic ranking overlap drops after core update

0 Kommentare